Une équipe de chercheurs de l’École de médecine ICAHN de Mount Sinai a développé une nouvelle méthode pour identifier et réduire les biais dans les ensembles de données utilisés pour former des algorithmes d’apprentissage automatique – additionnant un problème critique qui peut affecter la précision du diagnostic et les décisions de traitement.

Les résultats ont été publiés dans le Journal of Medical Internet Research. L’article est intitulé «Détection, caractérisation et atténuation des biais raciaux implicites et explicites dans les ensembles de données de soins de santé avec l’apprentissage des sous-groupes: étude de développement et de validation des algorithmes».

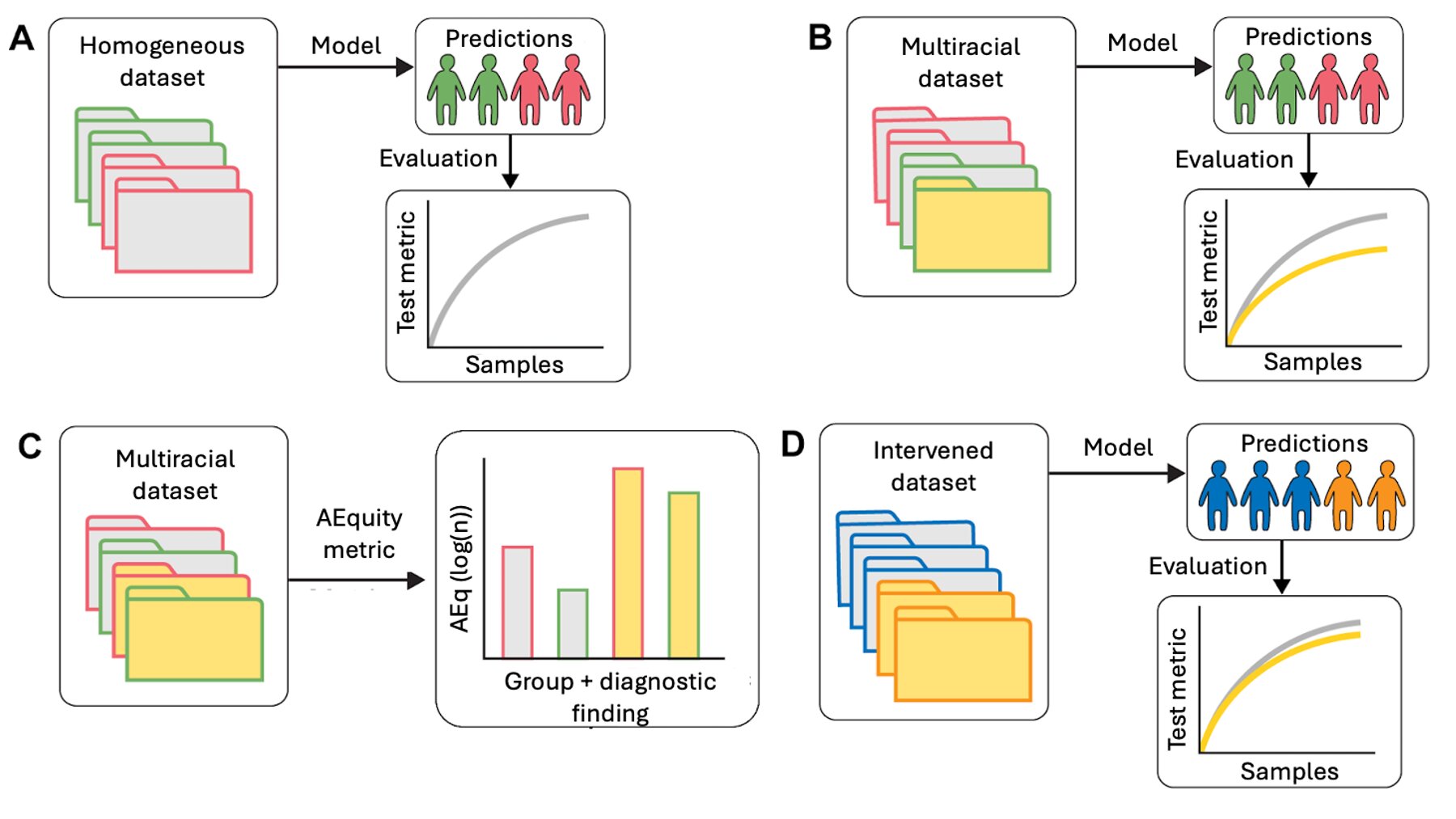

Pour résoudre le problème, les enquêteurs ont développé Aequity, un outil qui aide à détecter et à corriger les biais dans les ensembles de données sur les soins de santé avant d’être utilisés pour former des modèles d’intelligence artificielle (IA) et d’apprentissage automatique.

Les enquêteurs ont testé AEQUIT sur différents types de données de santé, y compris les images médicales, les dossiers des patients et une enquête majeure en matière de santé publique, le National Health and Nutrition Examination Survey, en utilisant une variété de modèles d’apprentissage automatique. L’outil a pu repérer à la fois des biais bien connus et auparavant négligés dans ces ensembles de données.

Les outils d’IA sont de plus en plus utilisés dans les soins de santé pour soutenir les décisions, allant du diagnostic à la prédiction des coûts. Mais ces outils ne sont aussi précis que les données utilisées pour les former.

Certains groupes démographiques peuvent ne pas être représentés proportionnellement dans un ensemble de données. En outre, de nombreuses conditions peuvent se présenter différemment ou être trop diagnostiquées entre les groupes, selon les enquêteurs. Les systèmes d’apprentissage automatique formés sur de telles données peuvent perpétuer et amplifier les inexactitudes, créant une boucle de rétroaction de soins sous-optimaux, tels que des diagnostics manqués et des résultats involontaires.

« Notre objectif était de créer un outil pratique qui pourrait aider les développeurs et les systèmes de santé à identifier si le biais existe dans leurs données, puis prendre des mesures pour l’atténuer », explique First auteur Faris Gulamali, MD. « Nous voulons aider à garantir que ces outils fonctionnent bien pour tout le monde, pas seulement pour les groupes les plus représentés dans les données. »

L’équipe de recherche a rapporté que l’Aequity est adaptable à un large éventail de modèles d’apprentissage automatique, des approches plus simples à des systèmes avancés comme ceux qui alimentent les modèles de grande langue. Il peut être appliqué à des ensembles de données petits et complexes et peut évaluer non seulement les données d’entrée, telles que les résultats de laboratoire ou les images médicales, mais également les sorties, y compris les diagnostics prédits et les scores de risque.

Les résultats de l’étude suggèrent en outre que l’AEquity pourrait être utile pour les développeurs, les chercheurs et les régulateurs. Il peut être utilisé pendant le développement des algorithmes, lors des audits avant le déploiement, ou dans le cadre d’efforts plus larges pour améliorer l’équité des soins de santé AI.

« Des outils comme Aequity sont une étape importante vers la construction de systèmes d’IA plus équitables, mais ils ne sont qu’une partie de la solution », a déclaré l’auteur correspondant principal Girish N. Nadkarni, MD, MPH, président de l’Institut de santé numérique de Windreich, et le Dr. Arthurg Professeur de médecine à la médecine de l’Icahn et du chef de la médecine de l’Icahn et de l’agent de médecine Icahn à l’Icahn Professeur d’Icahn à l’Icahn SCHIEL OF MEDICINE, et à l’officier de l’AI et au Chief Ai Officier AI Oftom of Medicine à l’Icahn Sparol du système de santé Mount Sinaï.

« Si nous voulons que ces technologies servent vraiment tous les patients, nous devons associer les avancées techniques avec des changements plus larges dans la façon dont les données sont collectées, interprétées et appliquées dans les soins de santé. La fondation est importante, et elle commence par les données. »

« Cette recherche reflète une évolution vitale dans la façon dont nous pensons à l’IA dans les soins de santé – non comme un outil de prise de décision, mais en tant que moteur qui améliore la santé dans les nombreuses communautés que nous servons », explique David L. Reich MD, directeur clinique du Mount Sinai Health System et président de l’hôpital Mount Sinai.

« En identifiant et en corrigeant les biais inhérents au niveau de l’ensemble de données, nous abordons la racine du problème avant qu’il ait un impact sur les soins aux patients. C’est ainsi que nous établissons une confiance plus large de la communauté dans l’IA et nous assurons que les innovations qui en résultent améliorent les résultats pour tous les patients, et pas seulement ceux qui sont les mieux représentés dans les données.